本文是一篇计算机论文,为了解决SEGAN模型训练过程中梯度消失的问题,本文提出了一种基于自注意力的SEGAN语音增强方法,提升模型对语音特征的学习能力。经过实验证明,本文研究方法,在不同测试集上,具有较好的语音增强效果。

第一章 绪论

1.1研究背景及意义

语音增强技术是现代通信领域最重要的技术之一,我们每天听到的声音都会带有不同的噪声,语音增强技术就是帮我们提高语音的质量,减少这些嘈杂的噪声,提升语音质量,改善语音可懂度。语音增强算法在某种程度上能抑制环境中的噪声[1]。

在很多场景下,我们都需要对语音信号进行增强,例如,在人声嘈杂的地铁中,使用手机进行通信时,通信信号中往往带有大量嘈杂的环境音,这些噪声往往会影响通信的质量。在地空通信系统中,飞机驾驶舱中的噪声对飞行员通信的声音造成严重的干扰,造成双方信息的不匹配。使用助听设备的听障人士,会因为环境中的大量噪声,从而产生生理上的听觉不适,进而感到交流困难。这些情况下,我们需要利用语音增强算法改进语音的质量和可懂度。

在理想的情况下,我们希望语音增强算法既可以改善语音的质量,又可以提升语音的可懂度。但实际上,大多数的算法仅改善语音的质量,在处理语音背景噪声的同时,也会引入语音失真,损坏了语音的可懂度。因此,在不明显引入语音失真的同时,且对噪声部分进行的有效地抑制,成为了人们研究的重点内容。

在语音增强任务中,可以按照通道数划分为单声道语音增强和多声道语音增强,单声道语音增强一般利用语音信号的频域和时域信息,相较于多声道语音增强来说,具有成本低,算法通用性强,应用场景更丰富等优点,但在方法实现上更具有挑战性[1]。而多声道语音增强则可以利用语音信号的频域、时域和空间域的信息对信号进行处理,但需要对麦克风位置和声源的空间位置两个因素进行考虑,且硬件设计上难度极大,成本较高等缺点。故本文主要研究单声道上的语音增强。

1.2国内外研究现状

1.2.1传统语音增强方法的研究现状

语音增强的研究始于上世纪60年代,经过近几十年的发展,取得了一些进步,得到了广泛的应用。 谱减法是最早被应用于语音增强的算法,它由Boll等[2]在1979年提出。该方法首先对背景环境中存在的噪声进行假设,假设这些噪声是加性噪声。随后,从带噪语音信号中减去假设的噪声信号,从而得到干净语音信号,并对估计的噪声谱进行更新。基于这种方法的前提是背景环境中的噪声信号是平稳的或者是缓慢变化的信号,这样对噪声谱的更新每次的差异很小。然而,在实际操作的过程中,常常会对噪声谱产生错误的估计,从而让噪声谱中出现一些负值。通常,处理噪声谱中负值的办法是,对出现负值的地方进行半波整流,将出现的负值重新设置为0。但是,经过这种处理后的信号谱中会出现一些小的、独立的峰值,形成听觉上的“毛刺”感,类似于乐器的破音,因此这种现象被叫做“音乐噪声(Musical Noise )”。为了解决“音乐噪声”问题,Boll等[2]采用的方法是:对于谱减法中出现负值的地方,依据相邻帧之间的最小值,从而设定一个下限。而不是单纯的将其统一的设为0。由于,该方法需要后续帧的语音谱,因此,无法在实际生活中得到应用。Berouti等[5]在谱减法中添加一个过减因子α和谱下限参数β,以此减少语音在谱减过程中的失真情况,同时也能控制“音乐噪声”的大小。然而,在实际情况中,各种各样的噪声在不同的频率范围内对语音的干扰是不相同的。而Berouti在文中却认为噪声对所有频率产生的影响是相同的,因而仅设置了一个过减因子,从而使该方法无法解决实际中的问题。Lockwood等[6]针对上述问题,提出了一种基于噪声补偿的非线性谱减(Non-linear Spectral Subtractor, NSS)法,在该方法中,将过减因子与频率相结合,提升了谱减法的性能。

第二章 生成对抗网络的相关理论

2.1生成对抗网络基本原理

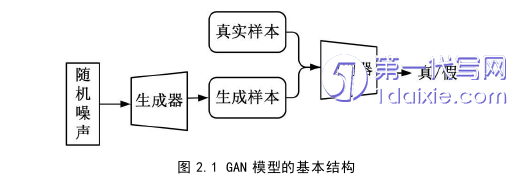

生成对抗网络(GAN)通常是由生成器(Generator, G)和判别器(Discriminator, D)两部分组成,GAN模型的基本结构如图2.1所示。而GAN本质就是生成器G与判别器D相互进行对抗训练,最终达到零和博弈状态。

生成器G主要负责生成数据样本,它以随机噪声向量z作为输入数据,z在一般情况下服从高斯分布或者均匀分布。噪声向量送入生成器G后,通过映射得到新的生产样本G(z)。而判别器D主要负责判别生成的数据,它是一个二分类器,以真实样本x和生成样本G(z)作为输入,并对送入到判别器的数据进行判别。输入样本为真实样本x时,则判别为“1”,即真实样本,并输出一个较高的概率值;当输入样本为由生成器G生成的生成样本G(z)时,则判别为“0”,即虚假样本,并输出一个较低的概率值;随后生成器G与判别器D交替进行训练,利用反向传播,将判别器D的判别信息反馈给生成器G,生成器G通过收到的信息对模型中的权重值进行调整,通过不断的调整,使模型生成的生成样本G(z)慢慢地接近真实样本x。模型的训练以交替训练的方式进行,在此过程中,双方的能力均在不断的提升。

2.2 GAN模型的几种改进

由于GAN的结构和训练过程,使得GAN存在诸多的问题,如训练不稳定,并且模型难以训练,出现梯度消失的情况,很难到达我们期望中的纳什均衡状态。为了解决模型训练过程中存在的一些难题,众多研究人员对GAN模型开展了大量的研究工作。

2.2.1 cGAN

在无条件生成模型中,有时候模型生成的数据跟我们想要的数据不匹配,即无法控制模型的生成数据。而在模型中添加条件信息即可以控制模型的输出,从而指导模型的数据生成。Mirza等[41]依据此思想提出了条件GAN(conditional GAN)模型。

在cGAN的生成器G和判别器D中分别加入一个条件信息y,这样可以控制模型的生成样本更好地接近于真实样本。cGAN模型结构如图2.2所示,在生成器G中添加一个额外的条件输入层,条件信息y与噪声样本z进行拼接然后作为输入送入到生成器G中,随后进行训练。在判别器D中,同样也添加一个额外的条件输入层,条件信息y与真实样本x进行拼接然后作为输入送入到判别器D中,随后进行判别。

2.2.2 DCGAN

CNN模型在无监督学习工作中受到的关注较少,为了解决这个问题,Radford等[42]提出了基于CNN结构的无监督学习框架(Deep Convolutional GAN)DCGAN,DCGAN模型能有效改善GAN模型训练不稳定的问题。

DCGAN模型结构图如2.3所示,在DCGAN模型中,作者使用了全卷积网络结构,同时删除了以往方法中常用的池化函数,使用步幅卷积操作代替原来的池化层。同时,允许生成器G和判别器D学习自身的空间上(下)采样。为了提升模型训练时的收敛速度,在DCGAN模型中取消了全连接层。为了解决模型训练中存在的梯度爆炸问题,在DCGAN模型中加入了批归一化操作。同时,DCGAN模型中生成器G除了输出层均采用Relu激活函数,而输出层则使用Tanh激活函数,而在判别器D中则使用LeakyRelu激活函数。

第三章 基于梯度惩罚项的SEGAN语音增强方法 ................................ 27

3.1引言.......................................... 27

3.2基于梯度惩罚项的SEGAN ............................. 27

第四章 基于自注意力的SEGAN语音增强方法 .............................. 42

4.1引言............................. 42

4.2基于自注意力的SEGAN .................................. 42

第五章 总结与展望.............................. 56

5.1总结....................................... 56

5.2展望.................................... 56

第四章 基于自注意力的SEGAN语音增强方法

4.2基于自注意力的SEGAN

4.2.1自注意力机制

注意力机制起初受到人类视觉神经注意力机制的启发,人在关注某些信息时,往往会忽略一些非重点的信息。注意力机制是帮助模型从众多信息中捕捉到对当前任务更关键的信息,从而提升模型的准确率。

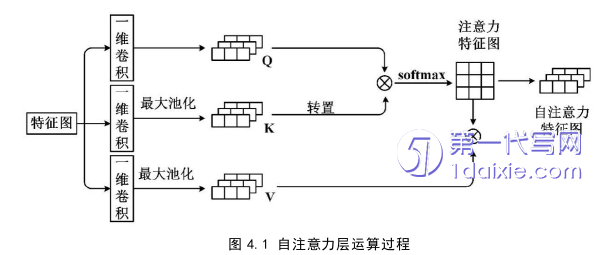

本章研究在生成器G和判别器D中分别加入自注意力层,其中生成器G编码部分和判别器D中自注意力层数由人为设置,生成器G解码部分自注意力层由计算所得。自注意力层运算过程如图4.1所示,第一步:将上一层得到的向量X送入自注意力层,查询Query矩阵和键Key矩阵均进行通道数整除8的一维卷积操作,值Value矩阵进行通道数整除2的一维卷积操作;第二步:键Key矩阵和值Value矩阵进行池化大小4×1,步长为4的最大池化操作;第三步:查询Query矩阵与键Key矩阵的转置相乘后进行softmax函数操作得到注意力特征图;第四步:将注意力特征图与值Value矩阵相乘得到自注意力特征图,将得到的自注意力特征图处理后作为输入送到下一层。

第五章 总结与展望

5.1总结

随着信息技术的发展,语音增强技术发挥着不可替代的作用。为了解决生成样本质量不佳的问题,本文提出了基于梯度惩罚项的SEGAN语音增强方法,在SEGAN模型的生成器G损失函数中添加梯度惩罚项,使得模型能更好的测量生成样本与真实样本间的距离。同时,为了解决SEGAN模型训练过程中梯度消失的问题,本文提出了一种基于自注意力的SEGAN语音增强方法,提升模型对语音特征的学习能力。经过实验证明,本文研究方法,在不同测试集上,具有较好的语音增强效果。本文的主要贡献点有以下几点:

1.针对SEGAN模型存在的难以训练、梯度爆炸等问题。在SEGAN模型中的生成器G损失函数中添加梯度惩罚项,通过梯度惩罚项指导模型的训练,让模型的训练更加稳定,提升模型生成样本的质量。

2 .针对SEGAN模型存在梯度消失、参数利用率低等问题。在SEGAN模型中加入自注意力层,通过扩大模型感受野的方式,使得模型能够提取到更多有关语音的特征信息,提升了模型的性能。

参考文献(略)