本文是一篇计算机论文,笔者认为未来将引入图卷积神经网络对频率特征和空间关系特征进行优化,从而得到偏差更少的融合特征,进而建立更多有效的映射关系,提高多模态特征的关联表示能力。

1 绪论

1.1 研究背景及意义

近年来,随着多模态数据的大量增加,信息的处理方式也随之多样化,越来越多的研究者从事多种模态数据的研究[1]。通过对多种模态数据的处理与融合,完成单种模态无法完成的任务。多模态融合技术将信息抽象到更高层的语义信息,这能够保留更多的有用的数据信息[1],更加深刻的提炼出其所蕴含的内容,舍弃那些无用信息,从而更有效的利用信息。目前,这项技术已有部分成效但也存在很多不足,成为大量的研究者研究的热点,也是人工智能广泛应用到生活中的关键点。

多模态关联表示的一个重要方向是视觉问答,视觉问答任务包含了计算机视觉和自然语言处理以及信息融合技术关系推理等等。随着计算机视觉和自然语言处理的快速发展,进一步加快了视觉问答以及图像标题生成的发展。

视觉问答任务,要实现将现实生活中的图片和图片相关的常见自然语言问题作为模型的输入,获得依据图片内容的答案作为输出。对于视觉问答任务,近年来的研究者是将图片和语言两种模态的信息先融合[1][2]。融合部分传统的方法是将两组特征向量拼接、或将两组特征向量对齐后逐元素相加、或将两组特征向量对齐后逐元素相乘。视觉问答任务通常分为三个部分,如图1-1所示,第一部分对输入的图像和问题文本进行编码,得到与图像对应的特征向量以及与问题文本对应的特征向量。第二部分使用融合方法将图像特征和问题文本特征相结合形成融合特征向量。第三部分依据融合特征向量对答案数据集进行打分,得分高的为对应图片问题的预测答案,这属于一种多标签分类的方法来预测答案[1][2],同时也有用回归方法来预测答案,用生成的方法来预测答案。使用不同的方法都可能产生不同的效果。视觉问答问题致力于让融合后的图像文本特征向量能够最完备的表现图像和问题文本所关注的信息进而更准确的预测答案。这自然也是这一任务的重点和难点。

1.2 国内外研究现状

随着互联网与人工智能技术的发展,各种信息大量涌现,并以图片、音频、文本等不同的数据形式呈现。这些不同的数据形式属于不同的模态。单一模态信息处理无法全面理解深层含义,而多模态融合能够连接不同模态信息,使不同模态之间的信息能够有效的配合,跨越不同信息模态之间的障碍,使得信息中蕴含的高层语义被全面理解并表达。多模态融合技术将信息抽象为高层的语义信息,这既能保留更多的有效数据信息,又能减少冗余降低计算开销。现有方法解决了一些问题,但也存在很多不足。多模态数据处理是近些年研究的热点,同时也是人工智能广泛应用到各个领域的关键点。

多模态数据处理的一个重要任务是视觉问答(Visual Question Answer, VQA)[1],视觉问答任务要实现将图片和与图片相关的问题作为模型的输入,通过模型,得出答案作为输出。视觉问答任务目前有大量难点需要克服,在图像编码部分涉及图像处理技术,在问题文本编码部分涉及自然语言处理技术,在中间潜变量部分涉及多模态融合技术。视觉问答是近些年最热门的多模态研究任务之一。视觉问答任务[1]正式是由Antol等提出,分别采用VGGNet和LSTM来提取图像特征和文本特征。Wu等人提出将图像用外部知识库来替换[2],将图像信息用文本来描述,这样视觉问答就变成了一般的问答问题。上述研究大多缺乏对数据的注意力分配,Lu等人提出不仅要用注意力机制决定关注哪些区域而且还要用注意力决定问题中哪些单词更加重要[3]。具有动态参数的CNN模型[4],根据不同的问题需要理解图像细粒度不同,将参数根据问题适应性表示。Li 等人提出依据图像更新问题[5],计算划分区域和问题的相关性,将相关性高的区域选出来以此对问题表示更新,不断迭代,最终给出预测答案。Jain等人提出使用变分自编码器和LSTM来构建新的算法[6],用于解决生成部分。Teney等人首次提出用图结构来融合表示图像信息和文本信息[7]。曾帅等人提出将建立以知识层面的自动问答系统[8],来代替关键词层面的自动问答系统。邓硙等人提出基于Yes/No反馈的方法[9],用Yes/No来得出预测答案是否正确,当为No时,对问题文本做消歧操作,然后生成多种问题,生成答案选择得分最高的作为最终预测答案。

2 相关理论知识与技术

2.1 Encoder-Decoder框架

Encoder-Decoder是深度学习中广泛应用的模型架构。Encoder是对输入信息进行编码,将输入信息经过非线性变换转换成中间态,公式为1 2,mSource x x x,1 2,mTarget y y y,1 2(,)mC F x x x其中Source表示输入信息,Target表示输出信息,C代表中间信息。Decoder是解码器,其根据中间信息C生成输出信息。编码解码结构的输入通常是图片、语音、文本等,输出通常也是图片、语音、文本。

2.2 注意力机制

2.2.1 软注意力机制

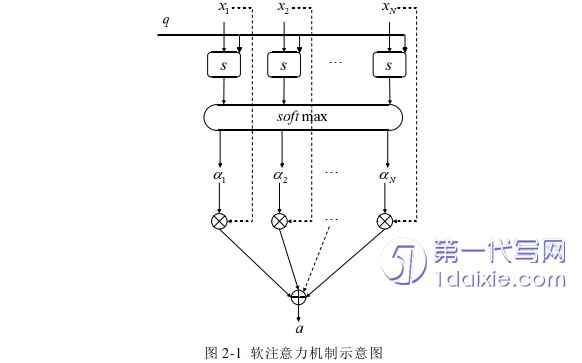

人在接受视觉信息时会选择感兴趣的区域进行重点关注,深度学习中的注意力机制类似于人处理视觉信息。注意力机制在深度学习中有着广泛的应用,能够很大程度上提高计算效率,在计算机视觉和自然语言处理领域中都有许多应用。比如在视觉问答任务中,模型只需要关注问题中所提到的目标对象区域,这样就可以很大程度上降低计算量。比如在自然语言领域的阅读理解任务中,需要根据一篇很长的文章来回答具体问题,而问题只和很少几个句子有关,文章的其他部分和问题根本没有关系,这时如果把整篇文章都放入神经网络中显然是很不明智的,只需要把相关的句子找出来送入神经网络中处理。

软注意机制在计算机视觉领域有许多相关的工作,比如在分割、检测、分类和生成模型方面。软注意的使用方法非常灵活,但本质都是使用特征获得权重得分,在用权重得分与特征结合获取相关注意力信息。不同的软注意力方法权重作用的方式有所不同,比如权重操作可以对原图像作用、权重操作可以对不同空间坐标的区域作用、权重操作可以对不同的通道作用、权重操作可以对不同历史时刻的特征作用。

3 基于空间关系与频率的视觉问答网络方法 ...................................... 18

3.1 相关研究 ................................................... 18

3.2 多维增强注意力模型 ...................................... 19

4 基于增强因果推断的视觉问答网络方法 ........................................... 31

4.1 相关研究 ............................................... 31

4.1.1 MuRel模型 ......................................... 31

4.1.2 因果关系的概念 ................................... 32

5 总结与展望 ................................................... 44

5.1 全文工作总结 ........................................ 44

5.2 未来工作展望 ............................... 44

4 基于增强因果推断的视觉问答网络方法

4.1 相关研究

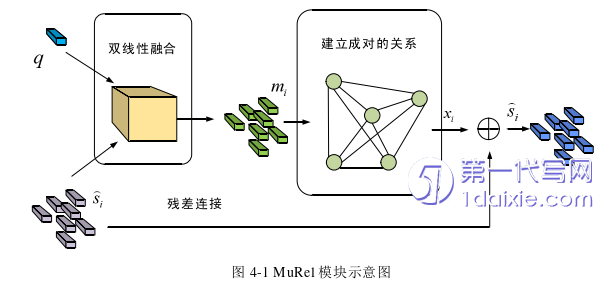

4.1.1 MuRel模型

一般的视觉问答模型虽然取得了一定的效果,但是注意力机制不能对图像和问题的关系进行推理。MuRel能够学习多模态关联关系[54],MuRel用大量的向量来表示问题和图像的推理关系,将向量结合成对以此来共同建立模型。MuRel模型没有使用传统的注意力机制,而是使用向量的表示方式,对各个目标区域和问题进行交互建模。输入图像表示为v,问题表示为q,预测答案表示为aˆ,传统的方法是将这一问题用分类方法处理。这个模型把图像中的目标用向量集合{}iv表示,然后结合空间坐标[,,,]ib x y w h,其中[x,y]表示目标框的左上角坐标,[w,h]表示目标框的宽和高。问题使用GRU编码[55]。

对于问题和图像特征的融合使用双线性融合方法,这种双线性融合能够学到输入维度之间的关系,模拟多模态交互作用,而且维持比较低的参数数量。将问题q和目标图像区域向量s进行结合,形成多模态嵌入,再进行多模态融合,希望每个视觉表示s都包含问题信息,使用基于三阶张量Tucker分解的方法来模拟两种模式之间的相互作用。双线性融合的公式为:

5 总结与展望

5.1 全文工作总结

视觉问答任务要实现将图片和与图片相关的问题作为模型的输入,通过模型,得出答案作为输出。多模态融合技术将信息抽象为高层的语义信息,这既能保留更多的有效数据信息,又能减少冗余降低计算开销。现有方法解决了一些问题,但也存在很多不足。

(1)针对现有视觉问答模型中细粒度信息以及空间关系信息表示不充分的问题,提出用离散余弦变换增加频率特征,以提高细粒度识别能力,同时降低平均池化带来的不利影响;提出增加关系网络,建立候选对象之间的关联关系,以增强对象之间的空间关系信息,避免误判注意对象,减少文本和图像特征出现对齐错误。利用前述两个模块对现有的自底向上和自顶向下的注意力模型和模块化共同注意力网络模型进行特征融合改进,得到多维增强注意力模型(BUDR)和模块化共同增强注意力网络模型(MCDR),实验结果表明,改进后的模型性能更好,在VQA v2.0数据集上,BUDR模型精确度达到67.12%,MCDR模型精确度达到71.02%。

(2)VQA现有模型倾向于学习数据中的单模态偏差,而且还存在学习无效区域偏置融合,因此模型的泛化性不强。在VQA-CP v2数据集中,现有模型的性能大部分都受到干扰。VQA-CP v2数据集,测试集中问题及对应答案的统计规律和训练集中问题及对应答案的统计规律不同,依靠单模态语言规律来预测结果的模型在测试集上精确度大幅下降。这些模型依靠一种模式的统计规律来预测答案,而不必考虑另一种模态。VQA v2数据集本身存在这个问题,为了模态之间的交互作用,让图像来指导问题回答答案,就必须解决单模态的偏置问题和无效区域偏置融合问题。本章通过将强化因果推断模型和S-MRL模型以及BUTD模型相结合,形成新的基于增强因果推断的视觉问答网络方法,克服了原有模型存在的语言偏置问题以及图像区域和语言错误匹配的偏置问题。实验结果表明,所提模型在最具挑战性的数据集VQA-CP v2.0中,比原有模型精确度有较大提高,而且所有指标均超过最新同类型模型。

参考文献(略)