本文是一篇计算机论文,本文在BiDA模型的基础上使用BERT模型预训练词向量,并且增加了Self-attention层,对融合后的文本做自注意力机制加深问题与文本的交互,突出二者之间联系较深的特征。实验结果表明,改进模型效果都有所提升。

第1章绪论

1.1选题背景及研究背景和意义

1.1.1选题背景

随着科学技术的进步与发展,医学与互联网的结合已成为现代信息化发展的必然趋势。目前,医学知识的获取主要基于传统搜索方式,例如百度百科、Google搜索引擎等,但这种方式难以满足用户的需求,不能给用户返回最直接的答案,而是返回大量相关的网页,用户需要对网页进行阅读和理解,才能从中找到想要的答案。另一方面传统搜索方式返回的网页质量参差不齐,会使用户在理解方向上出现偏差,得到错误答案。而智能问答系统能直接回答出简洁、明确的答案,为用户提供快速、准确的信息服务。所以在医学领域引入智能问答系统,能进一步提高医学知识获取的便捷性、准确性。

智能问答系统在众多领域中都取得了较好的效果,但在医学领域中仍面临很多困难。首先,医学问答系统依赖于高品质的医学数据集,其次,高质量、高效率的问答模型相对较少。因此需要将机器阅读理解引入医学问答领域,提高医学问答系统的效果,促进医学域数据集的分享。

在医疗卫生领域,机器阅读理解模型能对病历文本进行语义分析,提取病人生理指标和用药历史等信息,在病历库寻找相似病历,总结出可行治疗方案供医生参考。

本文收集医疗服务平台的问答数据建立数据集,并基于机器阅读理解模型构建医学域智能问答系统,解决用户在医学检索与理解方面存在的各种困难。

1.2国内外研究现状

1.2.1机器阅读理解研究现状

一、国外研究现状

早期著名的机器阅读理解(Machine Reading Comprehension,MRC)系统是由Lehnert等人[2]在1977年研发的QUALM系统。2013年,Richardson等人[4]构建了全新的机器阅读数据集MCTest,这是一个多项选择类数据集,在该数据集进行训练,模型准确率可达到63%~70%。由于MCTest数据集无法满足更复杂的机器阅读理解模型,学术界又开放RACE数据集和CBT数据集,二者的数据分别来源于中国学生的英语考试题和古登堡项目提供的书籍,答案需要模型联系上下文进行推理。

2015年,Hermann等人[5]建设了数据集CNN/Daily Mail,数据集中的数据以三元组<文章(c),问题(q),答案(a)>的形式存储。同时提出基于注意力机制的网络模型,该模型在CNN/Daily Mai数据集上能大幅提升。此后,机器阅读理解任务因其开放性和交互性在NLP领域中取得了更多关注,各种的模型和数据集接连被提出,如Standford Attention Reader,AS Reader,AoA Reader等模型,斯坦福大学的SQuAD数据集[6],微软研究院的MSMARCO[7],华盛顿大学的NewsQA[8],NarrativeQA[9]数据集等。

SQuAD[6]数据集是片段抽取式数据集的典型代表﹐数据来自维基百科。2016年Maluuba研究院提出NewsQA数据集,该数据集数据来源于CNN新闻,其中包含12万问答对,均基于人类自然语言编写。MSMARCO数据集[7]是具有代表性的答案生成式数据集,该数据集答案无法直接在文章中获取,需要模型进行推理。

第2章相关理论和技术

2.1机器阅读理解

机器阅读理解任务由一个四元组<D,Q,C,A>定义[37]。D为篇章(Document),由需要阅读的篇章或段落组成;Q为需要机器回答的问题(Question);C为候选答案(Candidate),是篇章中的单个实体或篇章中的片段;A是Q的正确答案(Answer),是C的一个子集。

现有的阅读理解任务可以概括为4类:完形填空、多项选择、片段抽取和答案生成。

完型填空类机器阅读理解最早出现,其灵感来源于测试阅读理解能力的完形填空题。完形填空类阅读理解任务是给定一个篇章D以及一个缺失某个词的句子Q,推测出Q中的缺失词。可直接通过规则获取数据集的问题和答案,不需要人工标注。

多项选择类机器阅读理解任务是根据给定的篇章D、问题Q和一系列候选答案集合C,根据模型从候选答案集合C中为问题Q选择正确答案A,多项选择类数据集中的问题和答案候选集由专家手工构建,并且答案候选集中的候选答案通常为3个或4个。

片段抽取类机器阅读理解任务是给定一个问题Q和对应的上下文篇章D,需要模型从D中抽取一个拥有最大化条件概率的连续片段作为问题的答案,片段抽取类机器阅读理解任务的答案片段来自上下文,预测答案和真实答案更容易进行匹配和比较。主要通过精确匹配率(EM值)、模糊匹配率(Fl值)、BLEU(BilingualEvaluation Understudy)值或ROUGE(Recall-Oriented Understudy for GistingEvaluation)值进行评估。

2.2 LSTM长短期记忆网络

长短期记忆(Long short-term memory,LSTM)的提出主要是为了解决长序列训练过程中的梯度消失和梯度爆炸问题。

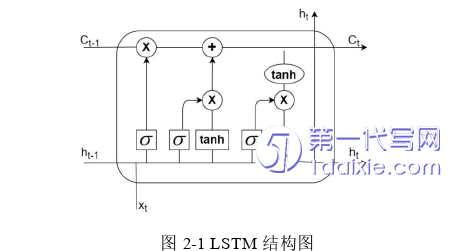

LSTM模型引入“门”结构的概念,对网络由前向后传递的信息进行有选择性使用,同时还使用一个记忆单元对隐藏层传输过程中的信息进行存储。LSTM模型引入了一个新的内部状态:记忆细胞,和三个控制信息传递的逻辑门:输入门、遗忘门、输出门。其结构如下图所示:

LSTM的关键是水平穿过图顶部的细胞状态,并且细胞状态只会进行少量微小的线性操作,其携带的信息基本保持不变的流过整条链。

第3章 医学域数据集构建 ................................. 13

3.1 引言 ....................................... 13

3.2 开源数据集 ................................... 13

第4章 基于注意力机制的机器阅读理解模型 ........................ 22

4.1 引言 ...................................... 22

4.2 任务定义 .................................. 22

第5章 基于预训练的机器阅读理解模型 ................................ 31

5.1 引言 ................................... 31

5.2 任务定义 ................................... 31

第6章系统设计与实现

6.2需求分析

6.2.1系统整体概述

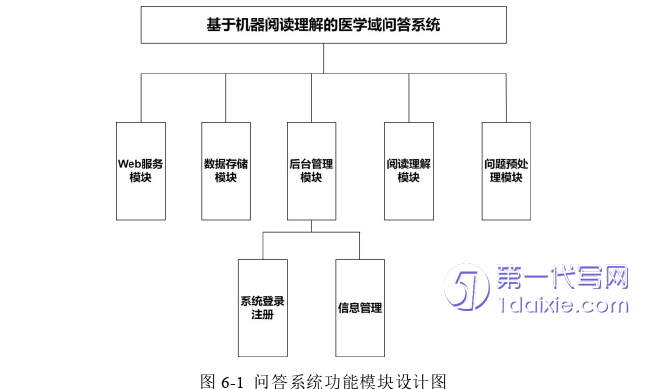

本章主要利用机器阅读理解技术和Web开发技术,设计和实现一个基于机器阅读理解的医学领域问答系统。问答系统的功能模块有Web服务模块、问题预处理模块、数据存储模块、阅读理解模块、后台管理模块。问答系统功能模块设计如图所示。

第7章总结与展望

7.1总结

机器阅读理解要求计算机根据给定的文本回答问题﹐是一项衡量机器对自然语言理解能力的任务。随着DuReader等大型数据集的出现以及深度学习技术的发展,中文机器阅读理解任务得到迅速发展,并被广泛应用于医学、教育等领域。本文对机器阅读理解模型的研究和医学域问答系统的实现进行了探索,主要工作如下:

1、数据集的构建

MedicalQA数据集的构建主要包括数据采集和数据处理。数据采集主要是分析数据所在页面的URL访问规则,并使用XPath方法解析页面数据,找到问题文本及答案文本所属URL,最后再次进行上述步骤获取该问题对应的答案文本。数据处理主要是解决格式混乱和数据冗余等问题,并借鉴DuReader数据集的质量控制办法,确保句子逻辑的准确性。

2、Match-LSTM和BiDAF模型的改进

本文在Match-LSTM模型的基础上添加了数据重构层,增加了重构后文本与问题之间关联性,提高了模型性能。本文在BiDA模型的基础上使用BERT模型预训练词向量,并且增加了Self-attention层,对融合后的文本做自注意力机制加深问题与文本的交互,突出二者之间联系较深的特征。实验结果表明,改进模型效果都有所提升。

参考文献(略)