本文是一篇计算机论文,通过结合不经意传输协议及秘密分享,本论文提出了一个抗共谋的源匿名数据洗牌方案Re-Shuffle。该方案利用不经意传输协议,解决了已有工作在共谋攻击下难以保护参与者梯度匿名性的问题。

第一章 绪论

1.1 研究背景及意义

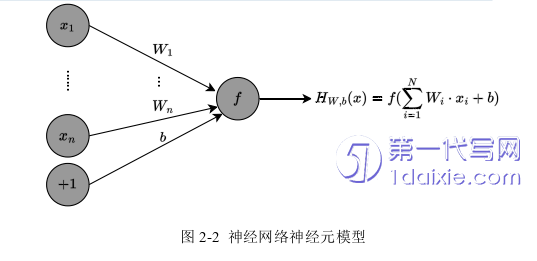

深度学习[1]是一种使用人工神经网络来建模和解决复杂问题的机器学习算法。它受到人脑结构和功能的启发,试图模仿我们大脑处理信息的方式。深度学习算法使用多层人工神经元(称为节点)来分析和理解不同输入和输出之间的关系。深度学习模型的神经元个数越多,网络层数越深,那么就可以模拟更为复杂的函数,其能够解决的问题也就越复杂。深度学习已成功应用于广泛的应用,包括图像识别、自然语言处理、语音识别、推荐系统以及自动驾驶等。这些只是深度学习众多应用的几个例子。随着该领域的不断发展和壮大,深度学习很可能在解决广泛行业和领域的复杂问题方面发挥越来越重要的作用。

尽管深度学习目前在许多领域具有广阔的应用前景,但它也给隐私保护带来了新的挑战。最关键的问题是如何确保训练数据隐私性。由于深度学习算法需要大量数据来训练,这些数据通常包含个人的敏感信息。确保这些数据的隐私是一个困难的问题。尤其在传统深度学习中通常采用集中化训练的方式以保证充足的训练数据。但是当用户私密数据由第三方公司收集和存储时,必然导致隐私泄露[2-4]。

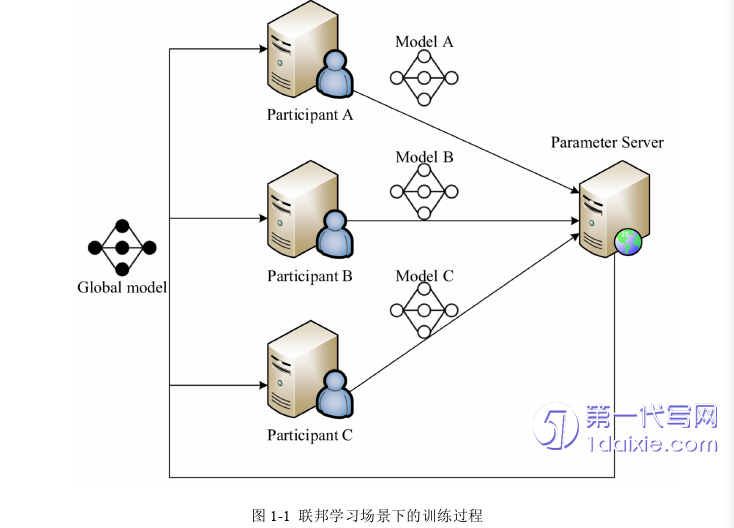

近年来,为了应对传统深度学习的隐私挑战,国内外衍生出了联邦学习、共享学习、知识联邦、联邦智能和异步联邦等一系列“联邦学习类”相关研究方向。联邦学习(Federated Learning, FL)由谷歌最先提出[5],它允许多个参与者与参数服务器合作来训练模型,同时保护每个参与者的隐私。在训练过程中,每个参与者将在本地数据集上训练自己的模型,并只将相应的梯度上传到参数服务器。从参与者接收到梯度之后,参数服务器可以聚合这些梯度以更新全局模型(图1-1显示了FL场景下的训练过程)。由于个人数据不需要上传到不受信任的参数服务器,FL已广泛应用于隐私敏感领域,如医学图像分析[6-8]、自动驾驶[9-11]以及5G[12-14]。

1.2 国内外研究现状

1.2.1 隐私保护联邦学习研究现状

隐私保护联邦学习的重点在保护训练参与者的隐私,Bonawitz等人[25]基于秘密共享的思想,提出了一种用于联合学习的安全聚合协议。具体地说,每个参与者通过执行Diffie-Hellman密钥交换协议与其他参与者生成成对密钥,并且每个参与者基于该密钥生成掩码并掩蔽其梯度。当服务器执行梯度聚合算法时,不同参与者的掩码将相互抵消,从而服务器可以获得聚合的原始梯度。Xu等人提出了一种基于方案 [25]的可验证FL系统[26]。该系统可以验证聚合结果的完整性,在确保服务器不会修改聚合值的同时保护参与者的梯度。Aono等人[24]提出了一种基于HE的安全聚合方案。在该方案中,每个参与者执行HE以加密自己的梯度,并将加密的梯度上传到参数服务器。然后,参数服务器可以在不解密的前提下聚合所有加密的梯度。Chen等人提出了基于TEE的训练完整性隐私保护FL方案[32]。参与者将在TEE中执行DL算法,并返回加密的梯度,该梯度将在服务器的TEE中解密和聚合。最近,Liu 等人提出了一种隐私增强型联合学习[19](Privacy-enhanced federated learning , PEPL)。在该方案中,可消除掩码被巧妙地添加到模型梯度中。PEFL不仅可以保护梯度的隐私,还可以检测毒化攻击。然而,PEFL中没有考虑非独立同分布(Non-independent identically distributed, Non-IID)数据集[35],并且PEFL中采用的HE也带来了沉重的计算负担,这使其不适合实际的FL环境。Warnat-Herresthal等人[36]在Nature上引入了群体学习的概念。他们将边缘计算、基于区块链的对等网络和协调统一起来,形成一种去中心化的机器学习方法。能够在不违反隐私法的情况下促进整合来自世界各地任何数据所有者的任何医疗数据。Feng等人[37]认为虽然联邦学习可以通过大量设备之间的人工智能模型的协作学习来保护数据隐私,但是,其效率低下且易受毒化攻击。进而提出了一种基于区块链的异步联邦学习框架(Blockchain-based asynchronous federated learning, BAFL),以保证联邦学习所需的安全性和效率。其中区块链确保模型数据不会被篡改,而异步学习则加快了全局聚合。并且通过使用一种新的熵权方法来评估在器件的BAFL中训练的局部模型的参与程度和比例。Ghodsi等人[38]通过组合神经网络激活层的交互协议和泰勒矩阵交互协议,实现了低成本的可验证云端深度学习方案SafetyNets。SafetyNets为某一类深度神经网络,即那些可以表示为算法电路的网络的激活层组成了一个新的、专门的IP协议,通过泰勒的矩阵乘法及IP协议实现端到端可验证性,与单独验证神经网络每一层执行情况的解决方案相比,大大降低了带宽成本,在语音及图像识别方面都实现了较高的验证准确率。

第二章 预备知识

2.2 针对联邦学习的常见攻击

2.2.1 针对梯度泄露引发的数据推理攻击

不同与毒化攻击,推理攻击更多的是对梯度隐私的威胁。攻击的发起方通常是进行梯度聚合的参数服务器。在FL训练过程中,参与者上传的梯度会包含本地隐私训练数据的信息。恶意服务器可以根据其梯度恢复其原始数据[24]。

3.2 系统模型、威胁模型及设计目标

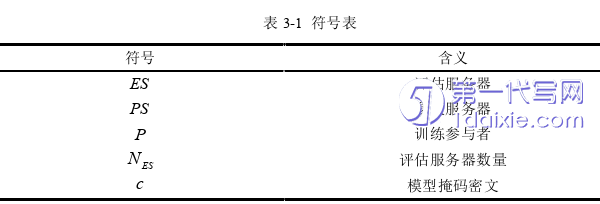

本节主要讨论系统架构和威胁模型。本节中出现的符号见表3-1:

在本节中对EPPFL及如下相关方案进行了功能性对比及实验仿真:隐私保护机器学习(Privacy-preserving Machine Learning, PPML)[25],拜占庭容忍梯度下降(Byzantine Tolerant Gradient Descent, BTGD)[18],拜占庭鲁棒分布式学习(Byzantine-robust Distributed Learning, BRDL)[66],屏蔽协作学习(Shielding Collaborative Learning, SCL)[23]和隐私增强的联邦学习(Privacy-enhanced Federated Learning, PEFL)[19]。

第三章 抗毒化攻击的高效隐私保护联邦学习协议研究 ············· 16

3.1 引言 ·································· 16

3.2 系统模型、威胁模型及设计目标 ·························· 16

第四章 支持掉线恢复及数据源匿名的联邦学习洗牌协议研究 ············· 38

4.1 引言 ························· 38

4.2 Re-Shuffle系统模型、威胁模型及设计目标 ····································· 38

第五章 总结与展望 ·········· 59

5.1 全文总结 ····································· 59

5.2 未来工作展望 ·································· 59

第四章 支持掉线恢复及数据源匿名的联邦学习洗牌协议研究

4.1 引言

论文第三章提出了一种新的隐私保护联邦学习框架EPPFL,其能够在保护梯度隐私的前提下进行毒化攻击检测。然而在EPPFL中参数服务器能够获取洗牌结果,因此当任意评估服务器与参数服务器合谋,则对应的参与者模型将会泄露。因此,如何在抗共谋的基础上保护参与者的隐私是一项亟需解决的问题。

源匿名数据收集方法为解决联邦学习中的共谋问题提供了一个新方向。具体而言,源匿名数据收集中参数服务器可以与每个参与者交互以获取随机的数据上传列表,但是无法获取特定数据的参与者身份。通过这种方式能够避免共谋攻击,且参数服务器能够直接在本地应用目前流行的毒化攻击检测方案[17][18]。尽管如此,现有的源匿名数据收集方案通常难以支撑动态的参与者[56],且部分方案依赖于可信的第三方机构。因此之间将现有的源匿名数据收集方案应用于FL存在问题。

综上,为解决这些问题,本章结合n-out-of-k OT协议及SS等SMC技术,提出了一种支持掉线恢复及数据源匿名的联邦学习洗牌协议Re-Shuffle,该协议无需可信机构,且通过OT保证每个参与者的洗牌结果的机密性。其次本文解决了传统数据收集协议中的参与者掉线问题,保证在不超出阈值数量个参与者掉线的前提下,协议能够正常执行。本文在分析部分给出了方案的安全证明,并通过实验验证了Re-Shuffle能够支持现有的主流毒化攻击检测方案。

第五章 总结与展望

5.1 全文总结

本文详细讨论了联邦学习算法的基本原理及面临的挑战。其中,重点针对FL中的隐私保护问题以及毒化攻击问题,提出了一种具备毒化攻击检测的高效隐私保护联邦学习方案EPPFL以及一种支持掉线恢复的高效联邦学习洗牌协议Re-Shuffle。

EPPFL在传统联邦学习架构中加入了评估服务器。参数服务器通过PRE及CRT等技术将参与者的模型匿名化上传至不同评估服务器,通过模型评估结果消去毒化模型的影响。此外,参数服务器通过对全局模型引入分层掩码,保证了恶意参与者无法根据全局模型推断隐私信息。

Re-Shuffle 通过OT及SS实现了匿名模型洗牌协议,相较于EPPFL,该方案保证了参数服务器无法获取每个模型的参与者信息,从而避免共谋攻击。此外,Re-Shuffle利用SS的同态性,保证了多用户掉线情况下协议的正常执行。相较于其他相关隐私保护方案,Re-Shuffle需要更小的计算开销。

参考文献(略)