本文是一篇计算机论文,本文分析了首个用于NAS算法研究的数据集NASBench-101,其中包含了大量已经训练好的模型架构和评估结果,利用这些数据研究者们可以快速进行NAS算法实现并在同等条件下进行算法性能对比。

第一章 绪论

1.1 研究背景

近年来,在大量数据的积累和日益精进的计算能力支持下,深度学习(Deep Learning,简称DL)技术已经在图像处理、文字理解和智能推荐系统等领域取得了巨大的成功。与传统的算法相比,DL的优势在于能够自动地进行特征提取和端到端的学习,特别是在处理数字图像、语音和文本信息等非结构性数据时,由于人类难以直观地对数据特征进行描述和提取,导致传统算法处理较为复杂和困难,而神经网络模型能够自动提取大量特征并进行处理,通常能够获得更好的性能表现。在将深度学习技术运用于一个新的研究任务时,研究者通常需要依赖自己过往的经验来完成神经网络模型的设计,如GoogLeNet[1]、ResNet[2]、VGGNet[3]、DenseNet[4]等经典模型都是由经验丰富的深度学习专家进行精心设计的。

深度学习的成功很大程度归功于资深的深度学习专家不断设计出更加高效的新型神经网络模型[5]。然而,由于深度学习技术的飞速发展和人类对计算精度需求的提升,神经网络所使用的操作算子形式变得越来越多,模型结构变得愈发复杂,网络模型深度也在不断加深。Jiang等人的研究[6]发现,增加神经网络的复杂度将会导致设计神经网络需要考虑的候选架构数量呈指数增长。海量的候选架构使得人为设计性能优异的神经网络变得越来越具挑战性,同时也需要花费更多的计算资源和时间进行模型性能评估。为了解决手工设计网络模型面临的挑战,一种名为神经网络架构搜索(Neural Architecture Search,简称NAS)的自动网络架构设计技术被提出,并被迅速运用到图像分类[7-10]、目标检测[11-13]、语义分割[14,15]和其他领域[16-18]中。

1.2 神经网络架构搜索发展现状

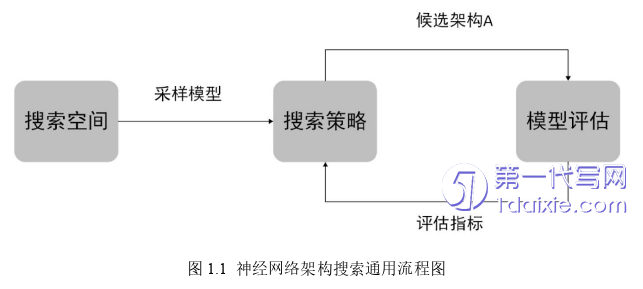

根据神经网络架构搜索算法设计的通用流程,本节将从NAS搜索空间、搜索策略以及模型性能评估策略三个方向对NAS的发展现状加以阐述和剖析。

1.2.1 搜索空间发展现状

早期人为手动设计的神经网络模型,如LeNet[20]和AlexNet[21]等经典模型都是采用链式结构将所有网络组件串联起来的。如图1.2(a)所描述的链式搜索空间中,一个链式网络架构主要由网络最大层数及各层的神经网络操作类型和参数所决定,其中第𝐿𝑖层的输入始终来自第𝐿𝑖−1层,且第𝐿𝑖层的输出作为第𝐿𝑖+1层的输入。EvoCNN[22]和MetaQNN[23]都是使用此类搜索空间的典型代表。

GoogLeNet[1]和ResNet[2]成功证明了具有多分支结构和跳跃连接的模型能够有效地缓解梯度消失和梯度爆炸对深度神经网络模型带来的负面影响,进而提升模型的整体性能。如图1.2(b)所示,受到人为设计网络结构的先验知识启发,另一种常见的搜索空间中引入了更加复杂的分支结构和跳跃连接。在这种情况下,不同网络层之间的连接也将成为模型架构变化的重要因素,能够显著地提升网络架构的复杂度。NAS-RL[24]、Large-Scale Evolution[25]和SMASH[26]等NAS算法都是使用这种搜索空间进行算法设计。

第二章 理论基础及关键技术

2.2 卷积神经网络

2.2.1 卷积神经网络基本原理

CNN是一种由大量卷积单元和池化单元构成的前馈神经网络,主要用于图像处理任务中[63]。CNN的结构是受到生物感知启发而来的,Hubei[41]通过对猫的视觉反应研究得出,动物视觉信号从视网膜传递到大脑皮层需要经过多种神经细胞激发,底层的简单细胞只负责视网膜上的局部区域,上层的细胞负责对多个区域的图像信息进行处理,产生更加复杂的视觉信号特征,具有更大的感受野。Kunihiko Fukushima提出了世界上第一个基于感受野设计的神经认知机(Neocognitron)模型[64],该模型主要包含了两种类型的细胞:S细胞和C细胞,S细胞主要负责对输入空间的特定特征模式进行提取,C细胞则主要对S细胞的输出进行轻微变形或者缩放处理。Neocognitron通常被看作CNN的雏形,S细胞和C细胞分别对应CNN中的卷积层和池化层。

一个卷积运算层中往往包含了多个卷积计算核,这些卷积计算核具有相同的尺寸,但每个卷积核中的参数都有所不同,不同参数的卷积核对应着不同的图像特征提取器。卷积层利用多个不同的卷积核在输入特征图的高和宽维度上进行扫描和计算,得到包含更多复杂特征的输出特征图,输出特征图的通道数量由卷积层的卷积核数所决定。图2.1显示了一个卷积计算的示意图,其中,最左边的5×5方格代表了输入特征图,蓝色区域表示当前卷积核正在进行计算的区域;中间3×3的蓝色方格表示卷积核;将卷积核中的参数和特征图区域的对应元素分别相乘,然后进行累加后得到输出特征图(最右边的方格)。从图中可以明显的看出,经过计算后输出特征图的维度缩小了,如果想要维持特征图的尺寸不因卷积而发生改变,可以在输入特征图的边界进行补零实现。此外,卷积核每次扫描移动的距离被称为步长(stride),步长能够控制相邻卷积的重叠区域大小,当步长越大时,重叠区域越小。

2.3 遗传算法

遗传算法是John Holland提出的一种基于种群进化的随机搜索算法,模拟了自然界中生物的自主进化过程[69]。遗传算法利用适者生存、优胜劣汰和交叉变异策略对种群中的个体进行更新,通过多次迭代获得种群中表现最为优异的个体。由于遗传算法具有容易并行实现、全局寻优能力强和对待求解问题约束少等特性,目前已经被广泛应用在智能装备制造和工业自动控制等领域[70]。一般来说,使用遗传算法进行搜索的设计过程如下:

(1)根据待求解问题设计搜索空间和基因编码方式,将实际问题转化为遗传算法能够处理的优化问题;

(2)从搜索空间中随机采样𝑛个个体作为初始种群,而每一个个体都对应了实际问题的一个可行解;

(3)使用适应度函数对种群里的每一个个体都进行适应度评估,一般来说,适应度值的高低反映了可行解在实际问题上的表现好坏;

(4)使用选择策略从种群中挑选优异的个体保留到子代种群中;

(5)根据交叉算子在种群里选择两个个体完成基因编码的交换,以此产生新个体;

(6)根据概率使用变异算子随机对个体的基因编码进行修改;

(7)重复步骤3-6,直至种群中最佳个体适应度达到某种收敛条件或种群迭代超过预设次数。

第三章 基于NASBench-101数据集的增量遗传搜索算法设计 ............................... 16

3.1 引言 ........................................... 16

3.2 NASBench-101数据集 ........................................... 16

第四章 增量式神经网络架构搜索算法优化 ................................. 30

4.1 引言 ...................................... 30

4.2 增量式搜索空间设计 ...................... 30

第五章 结论及展望 .................................. 46

5.1 结论 ..................................... 46

5.2 展望 ..................................... 47

第四章 增量式神经网络架构搜索算法优化

4.1 引言

第三章实验结果证明了增量遗传算法能够通过在搜索局部最优模型架构的情况下扩大搜索空间,从而快速发现性能卓越的模型架构。但NASBench-101为了在有限时间内实现对所有候选模型架构进行训练和评估,其对搜索空间做了较多限制。在实际进行网络架构设计过程中,研究者常常使用深度可分离卷积、空洞卷积等复杂卷积算子来降低模型参数量和提升模型性能,同时为了获得更优异的模型性能,使用更深的网络网络层数和更复杂的连接操作也是一种有效的模型性能提升方式。

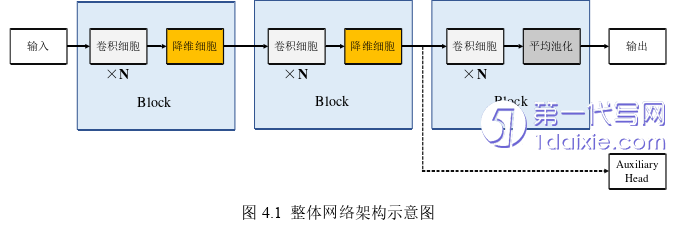

本章从实际网络模型设计的角度出发,结合手工设计神经网络的先验知识,设计了一个候选网络数量更多、连接更复杂以及候选网络算子更多的搜索空间,并针对该搜索空间重新进行了编码定义和搜索空间扩展策略的设计。同时为了实现快速对采样得到的候选网络模型进行性能评估,引入了ENAS[56]提出的权重共享策略来避免候选网络的重复训练。此外,本文还提出了一种改进的获得性遗传算法(Heredity Algorithm,简称HA)[78]作为搜索策略,以节点连接编码和网络操作编码为基本进化单元对个体基因进行编辑,并使用复写操作代替遗传算法中的交叉操作。最后对本文提出的算法在图像分类数据集上进行搜索和评估,并与经典的人工设计网络模型和其它神经网络架构搜索算法模型进行了对比分析。

第五章 结论及展望

5.1 结论

本文重点探究了图像分类任务中NAS算法设计存在的搜索效率低、计算开销大和算法泛化难的问题,基于NASBench-101数据集提出了一种增量搜索算法动态地进行搜索空间调整,利用局部搜索空间收敛速度快的特性来加快搜索进程,并为在更大空间进一步的搜索提供指导,以此加快算法搜索效率和精度。然后将该算法应用于图像分类模型设计中,并针对实际搜索场景对算法进行优化,最终获得了超越手工设计的经典模型和其它NAS算法搜索到的模型性能的自动化模型。 本论文的主要工作如下:

(1)本文分析了首个用于NAS算法研究的数据集NASBench-101,其中包含了大量已经训练好的模型架构和评估结果,利用这些数据研究者们可以快速进行NAS算法实现并在同等条件下进行算法性能对比。基于此,本文针对NASBench-101设计了应对的编码方案,并提出了一种增量遗传搜索算法,利用小搜索空间利于搜索的优点,快速得到性能较为优异的局部最优模型,并以局部模型为起点在更大的搜索空间进行搜索,从而得到性能更优的模型架构。此外,本文还介绍了一些目前较为主流的搜索算法,并将它们在NASBench-101中进行了实现。最后将本文提出的增量遗传搜索算法与这些方法进行了实验比较,结果证明本文提出的方法能够有效的加快最优模型架构的搜索速度。

(2)由于NASBench-101数据集中模型约束较多,整体搜索空间表示范围有限,和实际网络搜索场景有一定差异。为了进一步评估增量神经网络架构搜索算法的效率和泛化能力,本文结合手工设计神经网络的先验知识,针对实际图像分类模型的搜索任务重新设计了一种更复杂的搜索空间,并针对该空间设计了相应的模型编码格式和扩展策略。同时,提出了一种基于获得性遗传算法改进的搜索策略,通过扩展小空间中搜索到的局部最优模型提高初始种群的质量,并设计了以基因编码块为最小单位的复写算子和变异算子进行最优模型搜索。最后本文在C10上进行了分类模型构架的搜索,并将搜索到的模型应用到更复杂的C100上进行模型泛化能力测试。最后的结果表明,和一些手工设计的经典模型以及现有NAS算法相比,本文提出的方法能够在较短时间内获得超越现有算法的先进模型架构,C100数据集上的实验结果证明从增量搜索空间中找到的模型在复杂数据集上仍能取得较好的性能。

参考文献(略)