第一章 绪论

1.1 研究背景和研究意义

现如今网络信息技术迅速发展,传输设备的更新换代降低了网络数据上传者的准入门槛,大量的用户产生了海量的数据,也正因如此互联网中文本的质量参差不齐[1]。你可能经常遇到这样的情况:当你因为对文章的标题感兴趣而点开文章链接的时候却发现文章的内容与标题大相径庭。这些可恶的“标题党”对我们的时间和流量造成了极大的浪费。因此,我们急需一种技术自动地提炼出文本中的关键内容来节省我们的时间并精确找到我们感兴趣的文本,文本摘要自动生成任务应运而生。

文本摘要自动生成技术是自然语言处理任务和信息检索任务的核心任务,它可以在保留文本中心思想的前提下将长文本缩减为短文本。根据摘要的生成原理不同,我们一般将摘要的生成方法分成两种,一种是将文本中重要的句子抽取出来进行整合的抽取式摘要模型,另一种是在理解全文的基础上对文章内容进行改写的生成式摘要模型。其中较为成熟的是抽取式的自动摘要生成方法。抽取式的自动摘要生成方法是通过分析原文本文档中的句子将其中更能代表文章主旨含义的句子抽取出来,然后按照一定的规则将这些句子进行组合排列,最后得出一个较短的文本。抽取式摘要生成方法的大体实现思路为:根据需要将句子赋予不同的权重,为原文中的每一个句子进行打分并根据分数高低进行排序,然后按照先前所定的比例将得分较高的句子顺次输出,最后将输出的句子集进行排序连接组成摘要。生成式摘要又叫理解式摘要,与抽取式摘要不同生成式摘要更侧重于对文本内容的理解,就像人的阅读习惯一样,生成式摘要是在对原文内容理解的基础上利用原文中的关键词和短语对原文的主要内容进行改写。生成式的文本自动摘要生成方法更贴合现实实际的应用,但是实现起来也更为复杂,并且由于技术的限制生成的摘要可读性不高质量较差。结合两种摘要生成方法的优势,近年来有更多的研究学者开始将两者结合起来,先用抽取式摘要自动生成的方式将原文本进行精炼,再用生成式摘要自动生成的方法改写摘要。此外我们还可以根据原文本的数量将摘要生成任务分为单文本文档摘要和多文本文档摘要,本文的研究范围是单文本文档摘要生成。

..........................

1.2 研究现状及分析

自上世纪四五十年代起就有 NLP 学者们认识到了摘要自动生成任务的研究价值,在这技术快速发展的七十年中研究者们提出了许多实用的方法,从最初的机器学习的方法到深度学习网络与人工智能的应用,自动摘要技术领域取得的好成绩层出不穷。尤其在深度学习网络应用在自然语言处理任务中后,学者们对神经网络的改进和注意力机制的研究使得各项自然语言处理任务的效果都有了很大的提升。本小节主要从摘要自动生成技术和注意力机制两个方面来介绍国内外的研究现状。

1.2.1 文本摘要自动生成的研究现状

文本摘要自动生成的方法可以分为两种,即有监督的方法和无监督的方法。我们可以简单的将无监督的方法理解为不需要人工过度参与的方法,这种方法直接从原文本中抽取片段,再经过人为的模型调参将片段整合成为摘要。无监督的方法效率较高比较适合数量庞大的文本生成摘要,但由于只是简单的原文本抽取与整理的过程所以相较于人工生成的摘要有较大的差距且很容易发生句子冗余的情况。有监督的方法则是将人工生成的摘要作为训练集通过机器学习或者神经网络的方法训练成一个端到端的模型,最终通过模型生成摘要。

我们还可以将无监督的方法进行一个更为细致的分类:(1)基于统计的方法。文本自动摘要技术发展初期由于技术的限制,研究者们大都使用简单的统计思想来完成自动摘要,他们选取文本中出现的高频率的词和重要的句子位置等简单的文本特征通过线性的人工增加特征权重来生成摘要。公认的自动摘要技术奠基人 Luhn[2]用“簇”(cluster)来表示关键词的聚集,后来的研究者们又据此研究出了出包含多关键词多句子片段生成文章摘要的方法[3]。此后学者们开始研究句子的位置信息所包含的内容与文章主要思想的关系,极具代表性的是 Baxendale[4]发现文章的第一句基本包含了文章的全部信息。(2)基于图模型的方法。图模型的方法是抽取式摘要生成的一种方法[5]-[7],它把原文中的句子看作是图的节点,句子间没有相似性那么这两个节点就不存在相应的边,反之则根据句子的相似性程度来作为边的权值,然后我们利用公式的迭代计算,将文章中权重较大的句子提取出来;层次分割的方法是一种根据文章层次按照比例抽取对应句子的方法[8]-[9],这种方法极大的确保了摘要中主题的全面性。

...........................

第二章 相关理论介绍

2.1 词向量与 BERT

词向量是一种可以把现实世界中存在的文字转换成数学公式可以进行计算和变换的向量的一种模型工具,但是我们都知道与图像的向量表示不同,单纯的将文字转化为向量是没有意义的,所以怎样将词与词之间的关系也通过向量表示出来,也是研究者们研究的热点问题。

...........................

第二章 相关理论介绍

2.1 词向量与 BERT

词向量是一种可以把现实世界中存在的文字转换成数学公式可以进行计算和变换的向量的一种模型工具,但是我们都知道与图像的向量表示不同,单纯的将文字转化为向量是没有意义的,所以怎样将词与词之间的关系也通过向量表示出来,也是研究者们研究的热点问题。

研究工作初期研究者们最常用的词表示方法是“独热”(One-hot)[34],顾名思义这种方法将每一个词的都表示成“独特”的一个。这种方法首先要确定一个向量维度,这个维度由词表中词的数量决定,然后用不同的向量来表示不同的词。这种方法在稀疏矩阵的表示中有存储简洁的优势,但其无法表示语义层面上词汇之间的相关信息这一点是致命的,无法表示语义关系也就无法发掘句子中的潜在关系,所以如何解决词表示过程中的语义问题成为后来研究者们研究的热点问题。与仅仅将词符号化表示的 one-hot 方法不同,Harris 提出了“分布假说”(distributional hypothesis)的构想:上下文相似相近的词,其语义也相似,这也是分布假说的理论基础[35]。在基于分布式表示的方法[36]中已经可以将意思相近或有联系的词表示出来,词编码模型的表征能力进一步增强。随后人们发现神经网络模型与分布式表示结合[37]可以解决之前的维度灾难问题,词向量可以表示更多的内容意味着从此在更为复杂的文章中我们也可以加入词向量的表示方法,由此,词嵌入模型开始迈入新的阶段。这一时期词表示方法进入快速发展时期,各种各样的词嵌入模型层出不穷[38]-[41],其中最具代表性的是 word2vec[42]。Word2vec 解决了一个句子中语义关系的表示可以完成自然语言处理工作中较多的任务,然而对于摘要生成这样的需要句子之间逻辑和语义关系的任务word2ve 贡献却不大。在引入负采样的思想后,BERT 的编码方式可以充分描述字符级、词级、句子级甚至句间关系特征。

............................

2.2 双向长短期记忆网络(Bi-LSTM)

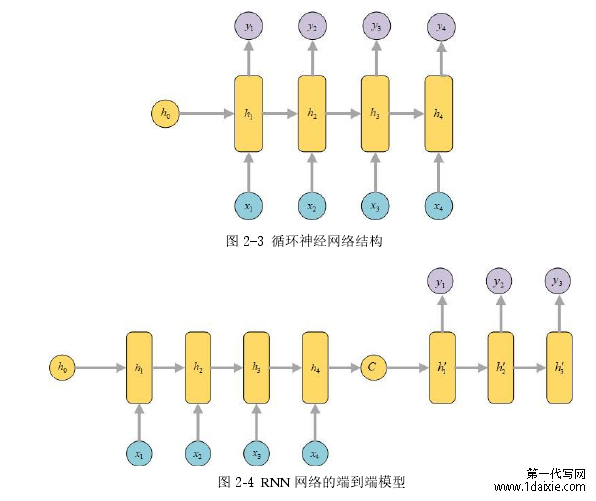

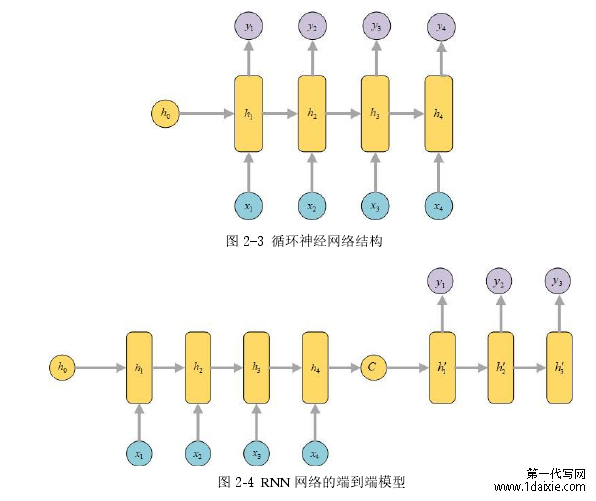

在 NLP 任务中我们都是将文本信息转化为序列进行输入的,所以在解码器模型中我们也一般使用在序列建模问题上表现较好的 RNN 或是 LSTM 来解决问题。在本章中我们先介绍 RNN 然后在此基础上来介绍 LSTM。

............................

2.2 双向长短期记忆网络(Bi-LSTM)

在 NLP 任务中我们都是将文本信息转化为序列进行输入的,所以在解码器模型中我们也一般使用在序列建模问题上表现较好的 RNN 或是 LSTM 来解决问题。在本章中我们先介绍 RNN 然后在此基础上来介绍 LSTM。

............................

3.1 基于微调的 BERT .............................23

3.2 融合注意力机制的双向长短期记忆网络.....................................24

3.3 基于微调的 BERT 和添加注意力机制的 Bi-LSTM 摘要自动生成模型 ...................................25

第四章 基于多头注意力机制的二段式生成式摘要模型 ........................ 33

4.1 本章模型构建....................................33

4.2 基于多头注意力机制的生成式摘要模型..............................34

第五章 文本摘要系统的设计与实现 ................................... 41

5.1 系统设计方案....................................41

5.2 数据获取与处理 ..............................41

第五章 文本摘要系统的设计与实现

5.1 系统设计方案

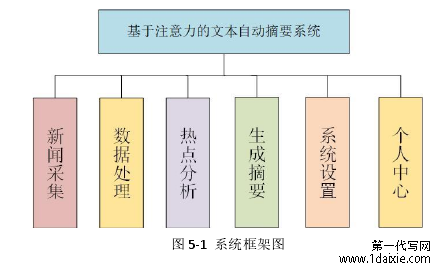

在进行系统开发前,我们先绘制了可以直观展示系统功能的模型框架图。我们分析从新闻数据的采集到生成摘要,我们需要对中间的数据进行处理,所以我们要添加相应的系统模块,完善处理流程。此外为了方便用户的使用,我们也添加了相应的用户设置模块。如图 5-1 所示模型中主要包含的模块有:新闻采集、数据处理、热点分析、生成摘要、系统设置和个人中心,其中生成摘要是系统的主要部分。其他模块的主要实现功能如下:新闻采集模块,利用网络爬虫技术采集新闻网页中的新闻并以固定的格式保存供其他模块使用;数据处理模块,根据文章提出算法的需要对新闻模块中采集到的数据进行处理;热点分析模块,根据当日采集新闻选取出当日各网站共同关注的新闻热点;系统设置和个人中心模块则实现了系统对于本身和用户的个人信息管理。

..........................

第六章 总结与展望

6.1 工作总结

互联网迅猛发展,互联网用户规模不断上升,由此也导致了网上文本数据的爆发式增长。怎样在这些海量的文本数据中快速准确的找到我们需要的文本,是当前亟待解决的问题。文本自动摘要技术是解决这一问题的最好方法。

本文对现有的摘要生成算法进行研究,借鉴国内外在摘要生成技术方面的研究经验与先进算法,分析总结了目前摘要自动生成算法的主流方法及存在的问题,并有针对性的提出了两种摘要模型,分别是基于句子级别 BERT 编码并融合注意力机制的 Bi-LSTM 摘要自动生成模型和基于多头注意力的二段式摘要模型。模型从编码阶段深度表示文本信息,通过注意力机制减少生成摘要的冗余性,又提出二段式精炼的方法解决生成摘要句子结构混乱的问题,并且通过实验证明了本文模型的有效性。最后在提出的两种算法的基础上,设计并实现了一个自动摘要系统,为本文模型提供了实际应用。本文所研究的工作主要总结为以下几个方面:

6.1 工作总结

互联网迅猛发展,互联网用户规模不断上升,由此也导致了网上文本数据的爆发式增长。怎样在这些海量的文本数据中快速准确的找到我们需要的文本,是当前亟待解决的问题。文本自动摘要技术是解决这一问题的最好方法。

本文对现有的摘要生成算法进行研究,借鉴国内外在摘要生成技术方面的研究经验与先进算法,分析总结了目前摘要自动生成算法的主流方法及存在的问题,并有针对性的提出了两种摘要模型,分别是基于句子级别 BERT 编码并融合注意力机制的 Bi-LSTM 摘要自动生成模型和基于多头注意力的二段式摘要模型。模型从编码阶段深度表示文本信息,通过注意力机制减少生成摘要的冗余性,又提出二段式精炼的方法解决生成摘要句子结构混乱的问题,并且通过实验证明了本文模型的有效性。最后在提出的两种算法的基础上,设计并实现了一个自动摘要系统,为本文模型提供了实际应用。本文所研究的工作主要总结为以下几个方面:

1.对于编码方式,我们通过梳理编码模型的发展介绍了 BERT 编码方式的优点及更适合摘要任务研究的原因,通过句子级别的编码方式深度挖掘原文本的语义信息。而双向的长短期记忆网络可以挑选出包含更多语义信息的句子,从而消除生成摘要的冗余句子。

2.由于人工书写摘要费用较高的限制,我们通过对 BERT 编码方式的微调特性进行研究,以少量的人工摘要为训练样本训练出了一个可以针对多领域的摘要模型。最后实验证明文章提出的 BERT 句子级别编码可以通过微调的方式提高模型的泛化性。

3.根据抽取式和生成式摘要生成方法的优缺点,提出了一种抽取式和生成式相结合的二段式摘要生成算法。将较短的一级摘要进行 BERT 词编码,多头注意力作为解码器,利用其可以多方面关注的特点在兼顾语义结构的同时也能注意各个词的输出位置,形成最终摘要。实验证明通过二段式摘要生成方法生成的摘要更贴近人工书写摘要习惯,优化句子结构,从而提高生成摘要的可读性。

参考文献(略)

2.由于人工书写摘要费用较高的限制,我们通过对 BERT 编码方式的微调特性进行研究,以少量的人工摘要为训练样本训练出了一个可以针对多领域的摘要模型。最后实验证明文章提出的 BERT 句子级别编码可以通过微调的方式提高模型的泛化性。

3.根据抽取式和生成式摘要生成方法的优缺点,提出了一种抽取式和生成式相结合的二段式摘要生成算法。将较短的一级摘要进行 BERT 词编码,多头注意力作为解码器,利用其可以多方面关注的特点在兼顾语义结构的同时也能注意各个词的输出位置,形成最终摘要。实验证明通过二段式摘要生成方法生成的摘要更贴近人工书写摘要习惯,优化句子结构,从而提高生成摘要的可读性。

参考文献(略)