第1章绪论

1.1话题演化的研究背景及意义

科学技术的不断发展,科技成果逐年增多,基于互联网的技术文章数以千万计,这些信息中存在大量的冗余。随着互联网的飞速发展,科技文献逐渐从传统的纸质论文集向数字图书馆方向不断发展,科技文献逐渐数字化,面对庞大的文献资料数据库,对文献的处理以及研宄就变得必要起来。传统的文献研宄领域主要是集中在对文献所包含的词汇进行定量的分析也就是对词频进行定量统计,这在发现热点话题方面很有帮助,但在对文献所包含的话题变动信息存在一定的局限性。话题模型则在一定程度上弥补了传统文献研究领域的不足,可以挖掘出文献的深层信息,对话题演化的研究则可以发现文献中话题的变化历程,对相关课题研究有一定的指导意义。这几年随着机器学习技术的发展,话题模型特别是LDA模型(Latent dirichletallocation)⑴作为挖掘文本语义信息的重要模型也被用到文献的研宄上来。LDA模型能够从文本中发现潜在的语义信息话题,通过话题可以将不同时间片内的文本关联起来,并且能够发掘出文本的语义信息。像LDA模型这样的话题模型以其高效的识别话题和提取语义信息的能力,被广泛的用于文献研宄领域,提高了对文献的处理水平,通过相关的话题可以更有效的发现相关的文献。本文基于种子文档和话题模型对科技文献进行研宄。种子文档的加入来降低背景噪对话题演化的干扰,使用话题模型对整个文集的文本信息进行话题提取,通过提取的话题对文本集合进行相关的分析。对话题的强度进行分析可以得到某一时间段内相关话题的受关注程度,从整个时间上来观察话题强度的变化,可以从强度方面发现话题的演化。话题内容体现了话题的基本信息,在时间线上对话题内容进行分析可以发现某一话题或者某一研宄领域的发展历程以及发展趋势。

……….

1.2话题演化的研究现状

话题演化包括话题强度演化和话题内容演化两方面:其中话题强度是指话题的稳定度或者关注度在时间线上的变化过程。话题内容演化是指话题内容在时间线上的演化历程。通过刻画话题强度和话题内容在时间线上的变化图对话题的演化趋势进行分析,可以从更深层次的角度来分析话题的发展。与话题演化相关的研究包括Allan J.于2002年提出的话题的识别和追踪技术(Topic Detection and Tracking, TDT)技术[2]。该技术最初是应用于网络新闻报道中,其本质是将输入的报道流划分为不同的话题类,并且在需要的时候建立一个新的话题类,这个过程等同于一个无指导的聚类过程,是一种增量聚类。但是TDT技术没有充分的利用话题的时间信息来进行话题演化过程的分析。近年来,话题模型得到了充分的发展。普利斯顿大学Bid等人于2003年在国际上首次提出潜在狄利克雷分布(Latent Dirichlet Allocation, LDA)模型[丨]:这是一种文本生成模型,从统计角度讲是一种三层贝叶斯模型,它将话题看成一个“词袋",将每一篇文档视为一个词频向量,并将文本信息转化为数字信息,易于建模。并且词袋没有考虑词与词之间的顺序关系,从一定程度上简化了问题的复杂性。在LDA模型中,每一篇文档代表了一些相互关联的话题所构成的一个概率分布,每一个话题又代表了一类单词所构成的一个概率分布,从这种隐含话题将文本与词相互关联起来,并将文本维度从iV维的词汇空间降到维的话题空间,有效解决了“维灾”问题,大大降低了文本处理的难度,较传统的向量空间模型更加有效。另外传统的模型假设文本只存在一个话题,这与实际的情况不符,在多话题的文本中难以发挥其作用。基于以上优点LDA模型在文本处理和文本挖掘等相关研究中应用逐渐广泛起来。

……….

第2章相关技术概述

2.1话题横型概述

话题模型是对文字中隐含信息的一种建模方法。话题可以用词汇表上的词语的条件概率分布来描述。与话题密切相关的词语,其条件概率就越大,反之则越小。话题可以看作一个词袋,装着若干个出现概率较高并且相关的词语。这些词语确定一类话题,并且词语之间也有相似的语义信息。对于一段文本,某些词语可能出现在多个词袋,即属于多个话题。在这种情况下一段文本可能是多个相关话题的混合体。话题和文档之间的关系可以从生成模型的角度来分析。生成模型认为一篇文档中的每一个词都是通过下述过程得到的:在文档中以一定概率选择了某个话题,并在这个话题中以一定概率选择某个词语。基于生成模型,如果要生成一篇文档,文档中的每个词语的生成概率为:P(词语I文档)=!>(词语丨话题话题I文档)。上式可以用矩阵乘法表示如下:[c]=[a>][e]。矩阵<5表示每个话题中每个词语出现的概率,即每个“桶"。矩阵e表示每篇文档中各个话题出现的概率,即一篇文档中每个话题所占的比例。假定有很多文档,比如大量的网页。首先,对所有文档进行分词处理,得到一个文档的词汇列表。这样,每篇文档可以视作词语的集合。对于每个词语,可以用它在文档中的出现次数除以文档中的词语总数作为它在文档中出现的概率。

………..

2.2LDA模型

1986年,Salton等人提出了 TF-IDF (文档的词频-反向文档频率)模型[17],该模型通过提取有一定文档区分度的词项来表征文档,不同的词项代表不同的特征,并且一篇文档的词项特征太多,维度规模较大。Deerwester提出了隐性索引模型(LSI)[i8],对文档得到的TF-IDF矩阵进行奇异值分解,得到词项的组合特征,并且能将同义词合并到同一词项特征中去。该模型实现了较大尺度的降维,但是没有对文档进行很好的生成解释。Hoffinaim提出了 pLSI模型(Probabilistic LatentSemantic Indexing)[i9],它是一种生成模型,引入隐含变量也就是话题这一特征,认为文档是由话题混合而成,文档中的词可由话题以一定概率生成,不同的词由不同的话题生成。将维度降到尺维也就是话题的数量,但是该模型的参数数量随着文本集的数量而线性增长。Blei等提出的LDA模型⑴不同于SVM直接从样本得到判别模型的方法,而是由样本生成样本自身所属的概率模型,再依据样本自身的概率模型进行分类判别,类似于贝叶斯模型,能够很好的生成话题的概率分布,并且模型的参数数量不随着文本集的增长而增长,LDA模型将文本的维度降到r维,也就是话题数量的维度。

……….

第3章基于种子文档和OLDA模型的话题演化.........15

3.1系统模型框架........ 15

3.2文本预处理 ........16

3.3LDA模型的实现........ 17

3.4基于种子文档的话题演化的改进方法........ 20

3.4.1基于种子文档的改进方法........ 20

3.4.2改进方法的实现 ........ 21

3.5基于OLDA模型的话题演化的改进方法........ 22

3.5.1基于OLDA模型的改进方法........ 22

3.5.2改进方法的实现........ 22

第4章实验结果与分析........ 25

4.1话题抽取对比分析........ 26

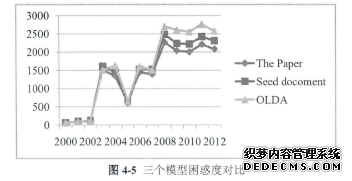

4.2强度演化对比分析........ 31

4.3内容演化对比分析........ 33

4.4模型泛化能力对比........ 36

第5章总结与展望........37

第4章实验结果与分析

话题演化相关文献中一般选取的语料大致可分为两类。第一类是论文集合,该类语料一般是国外知名的会议论文集,这种语料话题结构一般很一致,并且话题的演化趋势也较为稳定,一般不会出现较为大的波动。第二类是从网络上抓取的新闻语料,该类语料一般是从国内知名的门户网站进行抓取,该类语料需要后期处理,费时费力,并且时间粒度的确定也较为困难,话题演化趋势波动很大。本文选取论文集作为评价语料,选取国外知名会议NIPS从2000年到2012年录用的英文论文作为评价语料论文集有其天然的优势,时间粒度明显。由于会议是一年召开一次,故选取的时间粒度为年。NIPS所收录的论文大都是关于机器学习以及神经网络方面的论文,其论文集合反映了这两个方向近年来的大致发展方向,具有大致相似的话题结构。在对论文集合去除重复的文档后,总共有1739篇文档,将文档集按年作为划分粒度,划分出13个时间片,每一个时间片内的文档都存储在以时间命名的文件夹下,将每一年的80%的数据来参与模型的训练,另外20%的数据用来进行数据推断。

……….

结论

本文主要的研究内容是话题演化的方法,通过抽取出文本集合中的种子文档并将其加入到文本集中形成新的训练文本集合。然后将OLDA模型应用到新的文本集合上,抽取出文本集合的话题及其对应的概率分布。通过计算出不同时间片话题的强度和话题之间的相似度,从话题强度和内容上来对话题演化趋势进行分析。话题模型是一种有效的生成模型,它将话题看成一个装有具有近似语义特征的“词袋”,词袋内部词语词之间之间可以互换。话题模型可以有效的挖掘出文本的隐藏的信息,也就是话题信息。将文本降维到话题空间的维度,从而大大降低了文本处理的难度。本文首先总结了前人对话题演化的研宄进行总结,分别讨论了 LDA模型、TOT模型、DTM模型、CTDM模型等在话题演化方面的应用。这些模型各有各的优缺点,在特定的应用场景能够展现良好的演化效果。"本文方法是基于种子文档和OLDA模型来发现话题的演化过程。基准实验是单独使用种子文档方法和OLDA模型方法。本文通过对比实验来验证本文方法某种程度上的有效性和准确性。通过人工标记确定有意义的话题,计算话题的强度和话题之间的相似度,抽取热门话题,并生成话题在时间片上的演化图表。通过图表可以观察出本文的方法在某些方面确实有了一些提高。并在最后计算模型的困惑度,来对比模型的泛化能力。通过对比可以发现本文的方法‘的泛化能力略强于其他两个方法。

…………

参考文献(略)